As redes neurais recorrentes (RNN) são uma poderosa arquitetura de redes neurais utilizada em várias aplicações de aprendizado de máquina. Essas redes são especialmente eficazes em lidar com dados sequenciais, como o processamento de linguagem natural, reconhecimento de voz e tradução automática. Para compreender as RNN e sua importância, é essencial entender seu funcionamento, princípios e arquitetura.

Neste artigo, exploraremos em detalhes as redes neurais recorrentes, desde seus fundamentos até suas implementações práticas. Vamos examinar as diferenças entre as RNN e outras arquiteturas de redes neurais, como as redes neurais convolucionais (CNN), e como as RNN lidam com o processamento de sequências e dependências temporais.

Também discutiremos os elementos essenciais de uma RNN, como os neurônios e os estados ocultos, além de abordar os desafios enfrentados por essas redes, como o dilema do gradiente, e as soluções propostas para melhorar seu desempenho, como a arquitetura LSTM e o uso do GRU em modelos de aprendizado profundo.

Além disso, exploraremos as aplicações práticas das RNN, como a construção de modelos com as bibliotecas Keras e TensorFlow. Também examinaremos as tendências e avanços recentes nessas redes, bem como o futuro esperado para essa área de pesquisa.

Se você tem interesse em inteligência artificial, aprendizado de máquina e redes neurais, este artigo fornecerá uma compreensão abrangente e atualizada das redes neurais recorrentes.

Principais pontos do artigo:

- Definição e funcionamento das redes neurais recorrentes (RNN)

- Diferenças entre RNN e outras arquiteturas de redes neurais

- Princípios das RNN e processamento de sequências

- Arquitetura e elementos de uma RNN

- Importância do contexto e aplicações práticas da RNN

O que são Redes Neurais Recorrentes (RNN)

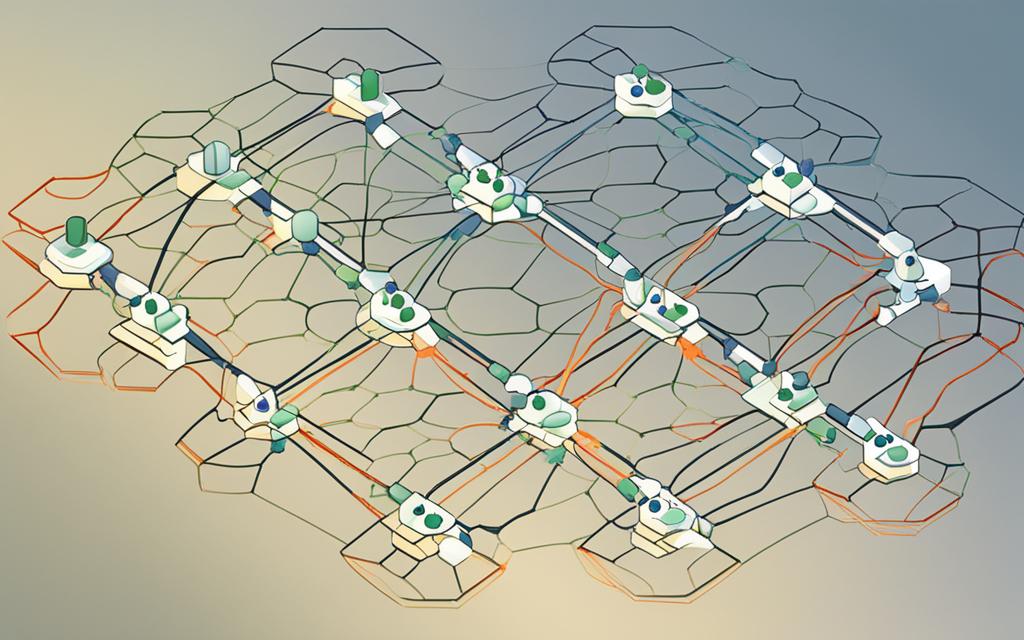

As Redes Neurais Recorrentes (RNN) são um tipo de arquitetura de rede neural que se destacam por terem conexões de retorno, permitindo que as informações percorram loops internamente. Essa característica permite que as RNN processem dados sequenciais, como texto ou séries temporais, levando em consideração o contexto anterior.

Definição e funcionamento das RNN

Em uma RNN, cada neurônio possui conexões diretas com a próxima camada, mas também possui conexões de retorno que permitem o acesso ao estado oculto anterior. Essas conexões de retorno permitem que a rede mantenha informações sobre contextos anteriores, tornando-a capaz de lidar com sequências longas e dependências temporais.

“As RNN são capazes de reter informações sobre o passado recente, o que lhes confere a capacidade de entender e aprender sequências, tornando-as adequadas para tarefas como tradução automática, reconhecimento de fala, análise de sentimento e muitas outras.”

O funcionamento de uma RNN envolve a repetição de um mesmo módulo para cada elemento sequencial, em que o módulo recebe a entrada atual e o estado oculto anterior. O estado oculto é atualizado com base na entrada e no contexto anterior, permitindo que a rede aprenda a representação de longo prazo das sequências.

Diferença das RNN para outras arquiteturas de redes neurais

Uma das principais diferenças entre as Redes Neurais Recorrentes e outras arquiteturas de redes neurais, como as Redes Neurais Feedforward (FNN), é a capacidade das RNN de processar sequências de entrada de comprimentos variáveis. Enquanto as FNN são limitadas a formatos fixos de entrada, as RNN podem lidar com dados sequenciais de tamanhos diferentes.

Além disso, as RNN levam em consideração o contexto anterior ao processar cada elemento sequencial, o que as torna especialmente adequadas para tarefas em que a ordem dos dados é importante, como em séries temporais.

Apesar de suas vantagens, as RNN também possuem desafios, como o desvanecimento ou explosão do gradiente durante o treinamento. No entanto, novas arquiteturas, como LSTM e GRU, foram desenvolvidas para superar essas limitações e aprimorar o desempenho das RNN.

Princípios das RNN e Processamento de Sequências

As redes neurais recorrentes (RNN) são particularmente adequadas para lidar com dados sequenciais, como textos, música, fala e tempo em geral. Essa capacidade exclusiva de processar sequências permite que as RNN capturem informações contextuais e dependências temporais, atributos essenciais em muitas tarefas de aprendizado de máquina.

Uma das principais características das RNN é a sua habilidade de processar entradas de comprimentos variáveis, tornando-as extremamente versáteis para diferentes cenários. Elas são capazes de considerar o histórico completo das entradas anteriores, permitindo que tomem decisões informadas com base nas informações contextuais disponíveis em cada ponto da sequência.

O funcionamento das RNN baseia-se em um princípio fundamental: a propagação de informação ao longo do tempo. Essa propagação é possível graças à presença de conexões recorrentes em seus neurônios, que permitem que informações do passado influenciem o processamento do presente e do futuro.

| Elemento | Descrição |

|---|---|

| Neurônios | Unidades de processamento que recebem e produzem saídas com base nas entradas e estados ocultos. |

| Estados Ocultos | Memória interna da RNN que mantém informações sobre eventos anteriores e permite que a rede aprenda com sequências de dados. |

| Camada de Entrada | Recebe a sequência de dados e realiza transformações nos mesmos antes do processamento. |

| Camada Oculta | Contém neurônios e estados ocultos da RNN, responsáveis pelo processamento e atualização dos estados ocultos. |

| Camada de Saída | Produz as saídas finais da RNN com base nos estados ocultos e nas entradas fornecidas. |

A importância do contexto na RNN

Em redes neurais recorrentes (RNNs), a capacidade de capturar e usar o contexto é essencial para o aprendizado eficiente de sequências. O contexto se refere às dependências temporais entre elementos de uma sequência, ou seja, a capacidade de compreender o significado e a importância de cada elemento em relação aos elementos anteriores e futuros.

Como a RNN lida com dependências temporais

As RNNs são projetadas para lidar com dependências temporais, permitindo que elas capturem e utilizem o contexto ao longo de uma sequência. Essa capacidade é possível graças a uma característica exclusiva das RNNs – os estados ocultos.

Os estados ocultos atuam como uma forma de memória para a RNN, armazenando informações sobre o contexto anterior e fornecendo insights sobre o contexto futuro. À medida que os dados são inseridos na RNN, os estados ocultos são atualizados, permitindo que a rede capture e utilize informações contextuais para fazer previsões ou tomar decisões.

O processamento de dependências temporais em RNNs é fundamental para uma ampla gama de tarefas, como previsão do próximo elemento em uma sequência, tradução automática, reconhecimento de fala e análise de sentimentos.

Aplicações práticas da memória em RNNs

A capacidade das RNNs de capturar e usar o contexto tem várias aplicações práticas. Alguns exemplos incluem:

- Tradução automática: As RNNs conseguem traduzir sequências de um idioma para outro, levando em consideração o contexto de cada palavra e a estrutura da sentença.

- Reconhecimento de fala: RNNs são utilizadas para transcrever e interpretar sequências de fala, reconhecendo e interpretando as palavras com base no contexto.

- Geração de texto: As RNNs são capazes de gerar texto coerente e relevante, levando em consideração o contexto das palavras anteriores e as regras gramaticais.

Essas são apenas algumas das muitas aplicações práticas da capacidade da RNN de capturar e utilizar o contexto. À medida que a tecnologia avança, espera-se que as RNNs sejam ainda mais utilizadas em diversas áreas, aproveitando todo o potencial de processamento de sequências e dependências temporais.

Desafios e Soluções: Dilema do Gradiente

Ao trabalhar com redes neurais recorrentes (RNN), um dos principais desafios enfrentados é o dilema do gradiente. Esse dilema ocorre devido à dificuldade das RNNs em lidar com dependências temporais de longo prazo, resultando em problemas de convergência e degradação do gradiente durante o treinamento.

O dilema do gradiente ocorre quando o gradiente da função de perda propaga-se através do tempo, e os valores do gradiente podem se tornar muito pequenos ou muito grandes à medida que são multiplicados em cascata ao longo das iterações da rede.

Esse problema interfere na capacidade da rede de aprender e generalizar padrões em sequências longas, limitando sua eficácia.

A fim de mitigar o dilema do gradiente, várias soluções foram propostas, sendo as principais:

- Gradiente Clipping: consiste em limitar o valor do gradiente para um intervalo pré-determinado, evitando a explosão do gradiente.

- Unidades de Memória de Longo Prazo (LSTM): a arquitetura LSTM, que será discutida na próxima seção, incorpora mecanismos específicos para controlar o fluxo do gradiente e preservar informações de longo prazo.

- Unidades de Recorrência com Portões (GRU): uma alternativa às LSTMs, as unidades GRU também são capazes de mitigar o dilema do gradiente, permitindo que a rede aprenda dependências temporais de longo prazo.

Essas soluções têm se mostrado eficazes no tratamento do dilema do gradiente e contribuem para o aprimoramento do desempenho das RNNs, permitindo que elas sejam aplicadas em uma ampla gama de tarefas de processamento de sequências.

“O dilema do gradiente é um desafio significativo no treinamento de redes neurais recorrentes, mas soluções como gradiente clipping, LSTMs e GRUs têm ajudado a superar esse obstáculo e melhorar a capacidade das RNNs de aprender e generalizar dependências temporais.”

Como o LSTM melhora o desempenho das RNN

O LSTM melhora o desempenho das RNN ao solucionar o problema do gradiente desvanecente, que é comum em redes neurais profundas. O gradiente desvanecente ocorre quando o sinal de erro propagado ao longo das camadas da rede diminui exponencialmente, dificultando a aprendizagem de dependências de longo prazo.

Através das portas e da estrutura de célula de memória, o LSTM é capaz de manter um gradiente constante ao longo da sequência, permitindo que a rede aprenda e preserve informações importantes. Isso possibilita a aprendizagem de dependências de longo prazo e contribui para o desempenho superior do LSTM em tarefas complexas, como tradução automática, análise de sentimentos e geração de texto.

O uso do GRU em modelos de aprendizado profundo

O mecanismo de atualização do portão (Gated Recurrent Unit – GRU) é uma variação das redes neurais recorrentes (RNN) que resolve o problema do desvanecimento do gradiente, apresentando um desempenho superior em modelos de aprendizado profundo. O GRU introduz dois novos portões – o portão de atualização e o portão de redefinição – para controlar o fluxo de informações dentro da rede.

Esses portões permitem que o GRU aprenda quais informações devem ser lembradas, descartadas ou atualizadas em cada etapa do processamento sequencial. Isso é particularmente útil quando se lida com sequências longas e dependências temporais complexas.

“O GRU é uma poderosa adição ao arsenal das redes neurais recorrentes. Sua capacidade de aprender e atualizar informações relevantes ao longo do tempo torna-a uma escolha popular em tarefas de aprendizado profundo que envolvem sequências e dados temporais.”

Com o uso do GRU, é possível melhorar a capacidade das RNNs de capturar dependências de longo prazo, evitando a perda de informações úteis durante o treinamento do modelo.

Vantagens do GRU:

- Mecanismo de atualização adaptável: o GRU adaptativamente aprende quais informações são relevantes para cada passo subsequente, permitindo que a rede atualize seu estado oculto com mais eficiência.

- Desempenho superior em tarefas com sequências longas: o uso do GRU ajuda a evitar o desvanecimento do gradiente, permitindo que a rede capture dependências de longo prazo com mais eficácia.

- Arquitetura mais simples: em comparação com a arquitetura da LSTM, o GRU tem menos portões e, portanto, menos parâmetros a serem treinados, facilitando a implementação e treinamento de modelos de aprendizado profundo.

O GRU é amplamente utilizado em uma variedade de aplicações de aprendizado profundo, como processamento de linguagem natural, tradução automática, reconhecimento de fala e composição musical. Sua capacidade de capturar e lembrar dependências temporais torna-o uma escolha valiosa para tarefas que envolvem dados sequenciais.

Exemplos de aplicação de RNN com TensorFlow

O TensorFlow é uma biblioteca de código aberto desenvolvida pelo Google para construção e treinamento de redes neurais. Assim como o Keras, o TensorFlow também suporta a implementação de modelos de RNN, por meio de suas APIs específicas.

Com o TensorFlow, é possível criar modelos de RNN personalizados, utilizando as operações e funções disponíveis na biblioteca. Além disso, o TensorFlow oferece recursos avançados, como o suporte a unidades de memória no modelo de RNN, facilitando o processamento de sequências de dados.

Nesta seção, apresentarei exemplos práticos de aplicação de RNN com o TensorFlow, abordando diferentes problemas como classificação de texto, previsão de séries temporais e tradução automática.

O futuro das RNN e avanços recentes

O campo de Redes Neurais Recorrentes (RNN) continua a evoluir rapidamente, impulsionado por inovações e avanços recentes no aprendizado profundo. Esta seção explorará as tendências emergentes e os desenvolvimentos futuros esperados para as RNN.

Inovações e tendências em RNN e aprendizado profundo

A comunidade de pesquisa e desenvolvimento em aprendizado profundo tem se concentrado na melhoria das RNN, buscando alcançar maior eficiência e desempenho. Algumas inovações e tendências notáveis incluem:

- Arquiteturas aprimoradas: Novos modelos de RNN, como as arquiteturas LSTM (Long Short-Term Memory) e GRU (Gated Recurrent Unit), foram desenvolvidos com o objetivo de superar as limitações das RNN tradicionais. Essas arquiteturas aprimoradas melhoram a capacidade de capturar dependências de longo prazo, permitindo o processamento eficiente de sequências complexas.

- Transferência de aprendizado: A transferência de aprendizado, um conceito fundamental no aprendizado profundo, também está sendo explorada em RNN. A capacidade de aproveitar o conhecimento prévio de modelos treinados em tarefas relacionadas tem o potencial de acelerar e melhorar o desempenho das RNN em várias aplicações.

- Aprendizado auto-supervisionado: O aprendizado auto-supervisionado tem emergido como uma abordagem promissora para treinar RNN em grandes conjuntos de dados não rotulados. Essa técnica permite que as RNN aprendam representações ricas, sem a necessidade de supervisão externa, o que pode levar a uma melhoria significativa no desempenho em tarefas específicas.

Desenvolvimentos futuros esperados para RNN

O futuro das RNN promete avanços emocionantes e progresso contínuo. Alguns dos desenvolvimentos futuros esperados incluem:

- Integração com outras arquiteturas: À medida que o campo do aprendizado profundo avança, espera-se uma maior integração entre RNN e outras arquiteturas neurais, como redes convolucionais e redes generativas adversárias. Essa colaboração entre diferentes modelos de aprendizado profundo tem o potencial de impulsionar a criação de soluções mais abrangentes e poderosas para problemas complexos.

- Aplicações em áreas diversas: À medida que a compreensão e o poder das RNN continuam a crescer, espera-se que seu uso se expanda para novas áreas e setores, como medicina, finanças, análise de sentimentos e personalização de recomendação, dentre outros. Essa diversificação de aplicações abrirá novas oportunidades e usos para as RNN.

- Melhorias na eficiência computacional: Um desafio contínuo nas RNN é a demanda computacional intensiva necessária para treiná-las e executá-las. Espera-se que futuros avanços em técnicas de otimização, bem como o aumento do poder computacional, levem a melhorias significativas na eficiência e velocidade de execução das RNN.

À medida que os pesquisadores e desenvolvedores continuam a explorar o potencial das RNN, é emocionante imaginar os avanços que o futuro reserva para essa poderosa classe de modelos neurais. A próxima seção abordará a conclusão do artigo e resumirá os principais pontos discutidos.

Conclusão

As redes neurais recorrentes (RNNs) representam uma poderosa arquitetura de redes neurais que permite lidar com dados sequenciais e dependências temporais. Através de neurônios e estados ocultos, as RNNs são capazes de manter a memória das informações anteriores e utilizá-las para processar novas entradas.

Embora as RNNs ofereçam benefícios notáveis, como a capacidade de capturar o contexto e lidar com dados de séries temporais, elas também apresentam desafios, como o dilema do gradiente. No entanto, soluções como a arquitetura LSTM e o uso do GRU têm demonstrado melhorar significativamente o desempenho das RNNs em tarefas complexas.

Com implementações práticas em bibliotecas populares de aprendizado de máquina, como Keras e TensorFlow, as RNNs podem ser facilmente utilizadas para uma ampla gama de aplicações. Essas bibliotecas oferecem um ambiente amigável para construir modelos de RNN e têm sido amplamente adotadas pela comunidade de aprendizado de máquina.

No futuro, espera-se que as inovações e avanços em RNNs e aprendizado de máquina continuem a impulsionar a evolução dessa arquitetura. A comunidade de pesquisa está ativamente envolvida em melhorar a eficiência, resolver desafios e explorar novas aplicações para as RNNs. Assim, podemos esperar um futuro emocionante para essa tecnologia promissora.

FAQ

O que são Redes Neurais Recorrentes (RNN)?

As Redes Neurais Recorrentes (RNN) são um tipo de arquitetura de redes neurais artificiais que são especialmente projetadas para lidar com informações sequenciais e temporais. Diferente de outros tipos de redes neurais, as RNN têm conexões que retroalimentam as informações de saída para as camadas anteriores, permitindo que elas tenham memória de curto prazo e considerem o contexto das sequências. Isso as torna ideais para tarefas que envolvem análise de linguagem natural, previsão de séries temporais, entre outras.

Qual é a diferença entre as Redes Neurais Recorrentes (RNN) e outras arquiteturas de redes neurais?

A principal diferença entre as RNN e outras arquiteturas de redes neurais está na capacidade de lidar com informações sequenciais e temporais. Enquanto redes neurais convolucionais (CNN) são mais adequadas para tarefas de visão computacional, as RNN são mais adequadas para tarefas que requerem processamento de linguagem natural e análise de séries temporais. Além disso, as RNN possuem conexões recorrentes, permitindo que elas tenham memória de curto prazo e considerem o contexto das sequências.

Como a RNN lida com dependências temporais?

A RNN lida com dependências temporais através da retroalimentação de suas saídas anteriores para as camadas anteriores. Essa retroalimentação cria um ciclo de feedback que permite à RNN reter informações sobre o histórico recente. Dessa forma, a RNN é capaz de capturar padrões e dependências em sequências temporais, o que a torna eficiente em tarefas como previsão de séries temporais, tradução de idiomas, geração de texto, entre outras.

Quais são as aplicações práticas da memória em RNNs?

A memória em Redes Neurais Recorrentes (RNNs) é muito útil em várias tarefas do processamento de linguagem natural. Algumas aplicações práticas incluem a geração automática de texto, onde a RNN pode ser treinada em grandes volumes de texto para gerar frases coerentes; a tradução automática, onde a RNN é treinada em pares de idiomas para traduzir um texto em um idioma para outro; e a análise de sentimento em textos, onde a RNN pode classificar se um texto possui uma conotação positiva, negativa ou neutra.

O que é o dilema do gradiente na RNN?

O dilema do gradiente é um desafio encontrado no treinamento de Redes Neurais Recorrentes (RNNs), no qual o gradiente, que é usado para ajustar os pesos da rede durante o processo de treinamento, tende a desaparecer ou explodir em sequências longas. Isso ocorre devido à retropropagação do gradiente ao longo do tempo, que pode levar a um gradiente muito pequeno ou muito grande, tornando o treinamento da RNN difícil. Felizmente, existem técnicas como as Redes Longas de Memória de Curto Prazo (LSTM) e as Unidades Recorrentes Fechadas (GRU) que foram desenvolvidas para superar esse desafio.

O que é uma Unidade Recorrente Fechada (GRU)?

A Unidade Recorrente Fechada (GRU) é uma arquitetura de redes neurais recorrentes que foi desenvolvida como uma solução para o dilema do gradiente em RNNs. Ela é baseada em unidades de memória que possuem mecanismos de portão para controlar o fluxo de informações. A GRU é capaz de reter informações importantes por mais tempo, superando as limitações do desaparecimento do gradiente em redes recorrentes. Além disso, a GRU tem menos parâmetros do que a arquitetura LSTM, o que geralmente resulta em treinamento mais rápido.

Como é feita a retropropagação ao longo do tempo (BPTT) nas RNNs?

A retropropagação ao longo do tempo (BPTT) é o algoritmo utilizado para atualizar os pesos em Redes Neurais Recorrentes (RNNs). Ele é uma extensão do algoritmo de retropropagação tradicional, adaptado para redes recorrentes. O BPTT calcula o gradiente em relação aos pesos da RNN através da propagação do erro ao longo de todas as etapas de tempo. Esse gradiente é então usado para atualizar os pesos da rede, permitindo que ela aprenda a capturar dependências temporais nas sequências de entrada.

Como implementar uma RNN com Keras e TensorFlow?

Para implementar uma Rede Neural Recorrente (RNN) com Keras e TensorFlow, siga os seguintes passos:

1. Importe as bibliotecas necessárias:

“`

import tensorflow as tf

from tensorflow import keras

“`

2. Crie uma camada de entrada utilizando a classe `Input` do Keras:

“`

input_layer = keras.layers.Input(shape=(…, …))

“`

3. Adicione camadas recorrentes à arquitetura da RNN, como LSTM ou GRU:

“`

rnn_layer = keras.layers.LSTM(units=…, return_sequences=…, activation=…)

“`

4. Conecte as camadas em sequência usando a função `Sequential` do Keras:

“`

model = keras.models.Sequential([input_layer, rnn_layer, …])

“`

5. Compile o modelo especificando a função de perda e o otimizador:

“`

model.compile(loss=…, optimizer=…)

“`

6. Treine o modelo com os dados de treinamento usando o método `fit`:

“`

model.fit(X_train, y_train, epochs=…, batch_size=…)

“`

7. Avalie o desempenho do modelo usando o método `evaluate`:

“`

model.evaluate(X_test, y_test)

“`

8. Faça previsões com o modelo usando o método `predict`:

“`

predictions = model.predict(X_test)

“`

Esses são os passos básicos para implementar uma RNN utilizando Keras e TensorFlow. Vale ressaltar que você pode personalizar a arquitetura da RNN e ajustar os parâmetros de acordo com a sua aplicação específica.

Quais são as inovações e tendências recentes em RNN e aprendizado profundo?

Nas últimas décadas, Redes Neurais Recorrentes (RNNs) e aprendizado profundo têm experimentado um rápido avanço. Algumas das inovações e tendências recentes incluem:

1. Modelos de sequência a sequência com mecanismo de atenção, que melhoram a capacidade da RNN de lidar com sequências de comprimentos variáveis.

2. O uso de Redes Neurais Convolucionais (CNNs) em conjunto com RNNs, permitindo que as redes combinem o processamento de informações locais e contextuais nas sequências.

3. Modelos de linguagem baseados em transformadores, como o modelo Transformer, que utiliza atenção multi-cabeça para capturar dependências de longo prazo em sequências.

4. O desenvolvimento de arquiteturas híbridas, que combinam diferentes tipos de redes neurais para abordar tarefas específicas, como as Redes Neurais Adversárias Generativas (GANs) e as Redes Neurais Geradoras de Linguagem (LSTMs).

Essas são apenas algumas das inovações e tendências recentes na área de RNNs e aprendizado profundo. A pesquisa nessa área continua avançando rapidamente, e espera-se que novas técnicas e abordagens sejam desenvolvidas para melhorar ainda mais o desempenho e a aplicabilidade das RNNs.

Qual o papel da memória em Redes Neurais Recorrentes (RNNs)?

A memória é um aspecto fundamental em Redes Neurais Recorrentes (RNNs), pois permite que a rede mantenha informações sobre o histórico recente das sequências de entrada. Isso é especialmente importante em tarefas que envolvem processamento de linguagem natural, onde a compreensão e a geração de texto dependem do contexto fornecido pelas palavras anteriores. A capacidade de armazenar informações em memória de curto prazo e considerar o contexto das sequências torna as RNNs altamente eficazes em tarefas como tradução automática, geração de texto, análise de sentimento e muito mais.

O que são Redes Estaduais de Eco (ESN) nas RNNs?

Redes Estaduais de Eco (ESN) são uma abordagem especifica de Redes Neurais Recorrentes (RNNs) que se baseiam no conceito de computação em reservatórios. Elas consistem em uma camada de entrada, uma camada de reservatório de neurônios recorrentes e uma camada de saída. A camada de reservatório é treinada apenas para representar os dados de entrada fornecidos e a camada de saída é treinada para realizar a tarefa desejada. As ESNs têm como vantagem a facilidade de treinamento e a capacidade de lidar com grandes volumes de dados de entrada. Elas são usadas em aplicações como previsão de séries temporais e reconhecimento de padrões.

Como ajustar os hiperparâmetros em RNNs?

Ajustar os hiperparâmetros em Redes Neurais Recorrentes (RNNs) é um processo empírico que envolve a seleção adequada dos valores para diferentes parâmetros, como a taxa de aprendizado, o tamanho do lote, o número de unidades em cada camada, entre outros. Para ajustar os hiperparâmetros em RNNs, é recomendado seguir as seguintes práticas:

1. Iniciar com valores-padrão: Comece com os valores-padrão fornecidos nos frameworks de deep learning, como TensorFlow ou Keras.

2. Explorar intervalos amplos: Varie os valores dos hiperparâmetros em diferentes intervalos para compreender sua influência no desempenho da RNN.

3. Utilizar validação cruzada: Divida os dados de treinamento em conjuntos de treinamento e validação para avaliar o desempenho da RNN com diferentes configurações de hiperparâmetros.

4. Pesquisa de grade e pesquisa aleatória: Realize experimentos utilizando a pesquisa de grade ou a pesquisa aleatória para encontrar a melhor combinação de hiperparâmetros.

Ao ajustar os hiperparâmetros em RNNs, é importante considerar a capacidade computacional disponível, o tamanho e a complexidade do conjunto de dados, bem como o tempo de treinamento necessário para cada experimento.

O que é aprendizagem por transferência em RNNs?

Aprendizagem por transferência em Redes Neurais Recorrentes (RNNs) é uma técnica na qual os conhecimentos adquiridos a partir de um modelo pré-treinado em uma tarefa específica são transferidos para uma tarefa relacionada. Ao utilizar um modelo pré-treinado como ponto de partida, a RNN pode começar com um desempenho melhor e requerer menos dados de treinamento para se ajustar a uma nova tarefa. Essa abordagem é especialmente útil em tarefas que possuem conjunto de dados limitado ou quando há similaridade estrutural entre as tarefas. No entanto, o ajuste fino do modelo pré-treinado ainda é necessário para que a RNN se adapte totalmente à nova tarefa. A aprendizagem por transferência tem sido amplamente utilizada em tarefas de processamento de linguagem natural, visão computacional e reconhecimento de fala.

Quais são as principais estruturas populares em Redes Neurais Recorrentes (RNNs)?

Existem várias estruturas populares em Redes Neurais Recorrentes (RNNs). Algumas das mais utilizadas incluem:

– Long Short-Term Memory (LSTM): Uma arquitetura de RNN que utiliza células de memória para reter informações importantes por longos períodos de tempo.

– Gated Recurrent Unit (GRU): Uma arquitetura de RNN semelhante ao LSTM, mas com uma quantidade menor de parâmetros.

– Redes Neurais Bidirecionais: Uma variação da RNN que considera informações do contexto antecessor e posterior para melhorar o desempenho.

Cada uma dessas estruturas possui vantagens e desvantagens, e a escolha da estrutura mais adequada depende da tarefa em questão e das características do conjunto de dados.

O que é um mecanismo de atenção em Redes Neurais Recorrentes (RNNs)?

Um mecanismo de atenção em Redes Neurais Recorrentes (RNNs) é uma técnica que permite que a rede selecione partes relevantes das sequências de entrada durante a fase de geração de saída. Esse mecanismo é especialmente útil em modelos sequência a sequência, onde informações específicas em uma sequência de entrada podem ser mais relevantes para a produção da sequência de saída desejada. O mecanismo de atenção ajuda a RNN a se concentrar nas partes mais importantes das sequências de entrada, melhorando o desempenho em tarefas como tradução automática, geração de texto e resumo de documentos.

Como implementar o mecanismo de atenção em Redes Neurais Recorrentes (RNNs)?

A implementação do mecanismo de atenção em Redes Neurais Recorrentes (RNNs) pode variar dependendo do framework utilizado. No entanto, em geral, o mecanismo de atenção pode ser implementado seguindo os seguintes passos:

1. Adicionar uma camada de atenção após a camada recorrente:

“`

attention_layer = keras.layers.Attention()

“`

2. Conectar a camada de atenção à saída da camada recorrente:

“`

output = attention_layer(rnn_output)

“`

3. Continuar a construção da arquitetura da RNN, adicionando outras camadas conforme necessário.

Ao implementar o mecanismo de atenção, é importante ajustar os parâmetros da camada de atenção, como o tamanho da atenção, para se adequarem à tarefa específica. Além disso, é recomendado treinar o modelo com dados rotulados para obter melhores resultados.

Como implementar uma RNN bidirecional?

Para implementar uma Rede Neural Recorrente (RNN) bidirecional, siga os seguintes passos:

1. Importe as bibliotecas necessárias:

“`

import tensorflow as tf

from tensorflow import keras

“`

2. Crie uma camada de entrada utilizando a classe `Input` do Keras:

“`

input_layer = keras.layers.Input(shape=(…, …))

“`

3. Adicione uma camada recorrente unidirecional, como LSTM ou GRU, para modelar a sequência de entrada em uma direção:

“`

rnn_layer = keras.layers.LSTM(units=…, return_sequences=…, activation=…, go_backwards=False)

“`

4. Adicione uma segunda camada recorrente unidirecional, mas agora modelando a sequência de entrada na direção oposta:

“`

reversed_rnn_layer = keras.layers.LSTM(units=…, return_sequences=…, activation=…, go_backwards=True)

“`

5. Concatene as saídas das duas camadas recorrentes para obter uma representação bidirecional:

“`

bidirectional_rnn = keras.layers.concatenate([rnn_layer, reversed_rnn_layer], axis=…)

“`

6. Continue a construção da arquitetura, adicionando outras camadas conforme necessário.

Ao implementar uma RNN bidirecional, é importante levar em consideração o desempenho computacional, pois o processamento das sequências ocorre em duas direções. Além disso, o tamanho e a complexidade do conjunto de dados também são determinantes para garantir bons resultados.

Add a Comment