Bem-vindo ao guia completo de aprendizado por reforço para iniciantes. Nesta seção introdutória, vou apresentar os fundamentos do aprendizado por reforço e como ele se aplica a você. Exploraremos juntos a definição e o funcionamento do aprendizado por reforço, sua história e evolução, e por que ele é tão importante no campo da inteligência artificial e automação.

O aprendizado por reforço é uma área da IA que se concentra em como os agentes podem aprender a tomar decisões através da interação com um ambiente. Ao receber feedback reforçado por meio de recompensas ou penalidades, os agentes aprendem a tomar ações que maximizam a recompensa acumulada ao longo do tempo. Essa técnica tem aplicações em uma ampla variedade de campos, incluindo jogos, robótica, automação industrial, finanças e muito mais.

A história do aprendizado por reforço remonta aos anos 1950, com as primeiras teorias de aprendizado de máquina. Ao longo dos anos, essa área se desenvolveu e evoluiu, impulsionada por avanços na computação e na teoria dos jogos. Hoje, o aprendizado por reforço é usado em várias aplicações do mundo real e continua a ser objeto de intensa pesquisa e desenvolvimento.

À medida que avançamos neste guia, vamos explorar os princípios fundamentais do aprendizado por reforço, os diferentes métodos de solução, as estratégias de aprendizado, as aplicações no mundo real e as tendências futuras. Espero que este guia seja um recurso valioso para você, permitindo que você compreenda melhor o aprendizado por reforço e seus benefícios em diferentes áreas.

Pontos principais deste guia de aprendizado por reforço:

- Aprendizado por reforço é uma técnica de IA que envolve aprendizado através da interação com o ambiente.

- O feedback reforçado por meio de recompensas ou penalidades é usado para treinar os agentes a tomar ações que maximizem as recompensas acumuladas.

- O aprendizado por reforço tem aplicações em várias indústrias e campos, incluindo jogos, robótica, automação industrial, finanças e muito mais.

- Neste guia, exploraremos os princípios fundamentais do aprendizado por reforço, métodos de solução, estratégias de aprendizado, aplicações no mundo real e tendências futuras.

- Esperamos que este guia seja um recurso útil para você compreender melhor o aprendizado por reforço e suas aplicações.

Introdução ao Aprendizado por Reforço

Nesta seção, vamos aprofundar os conceitos básicos do aprendizado por reforço. Você entenderá o que é o aprendizado por reforço, como ele funciona e quais são os seus principais componentes. Além disso, exploraremos a história e a evolução do aprendizado por reforço, desde os primórdios até as aplicações modernas. Você terá uma visão abrangente dessa técnica e de como ela tem se desenvolvido ao longo do tempo.

O que é Aprendizado por Reforço e como ele funciona

O aprendizado por reforço é uma técnica de inteligência artificial que permite que os agentes aprendam a tomar decisões através da interação com um ambiente. Nesse processo, o agente recebe feedback positivo ou negativo, chamado de recompensa, conforme suas ações. O objetivo do agente é maximizar a recompensa acumulada ao longo do tempo, aprendendo quais ações são mais vantajosas em diferentes situações.

Para que o agente aprenda, é utilizado o método de tentativa e erro. O agente explora o ambiente, realiza ações e, a partir das recompensas recebidas, ajusta suas estratégias para maximizar as recompensas futuras. Em outras palavras, ele aprende quais ações levarão a melhores resultados ao longo do tempo.

Um componente central do aprendizado por reforço é o processo de tomada de decisão de Markov (MDP), que modela o ambiente e as interações entre o agente e o ambiente. O agente usa o MDP para planejar suas ações futuras com base nas observações atuais e nas recompensas esperadas.

Para que o agente tome decisões mais inteligentes, é utilizada a Equação de Bellman, que calcula os valores esperados das recompensas futuras. Essa equação leva em consideração tanto as recompensas imediatas quanto as recompensas a longo prazo, permitindo que o agente avalie a qualidade das suas ações em diferentes estados do ambiente.

A história e a evolução do Aprendizado por Reforço

O aprendizado por reforço tem suas raízes na psicologia behaviorista, que estudava o comportamento dos organismos em resposta a estímulos. Os primeiros experimentos com aprendizado por reforço foram realizados na década de 1950, quando os psicólogos começaram a usar recompensas e punições para moldar o comportamento de animais e humanos.

A aplicação do aprendizado por reforço na inteligência artificial começou a ganhar destaque nas décadas de 1980 e 1990, com o desenvolvimento de algoritmos como o Q-Learning e o TD-Learning. Esses algoritmos permitiam que os agentes aprendessem a partir de experiências passadas e melhorassem suas estratégias de tomada de decisão.

Nos últimos anos, o aprendizado por reforço tem se beneficiado do avanço das redes neurais e da computação de alto desempenho. O uso de redes neurais profundas, combinado com técnicas de aprendizado por reforço, resultou no surgimento do aprendizado por reforço profundo (DRL), que tem alcançado resultados impressionantes em aplicações como jogos e robótica.

Métodos de Gradiente de Política em RL

Os métodos de gradiente de política em RL envolvem a otimização direta da política do agente para maximizar as recompensas. Em vez de estimar valores de recompensa, esses métodos otimizam diretamente os parâmetros da política do agente, que determinam quais ações são selecionadas em cada estado do ambiente.

Os métodos de gradiente de política empregam algoritmos de otimização, como o gradiente ascendente, para ajustar os parâmetros da política de forma a maximizar a recompensa esperada. Eles aprendem iterativamente, coletando amostras do ambiente, calculando gradientes e atualizando os parâmetros com base nesses gradientes.

Esses métodos são amplamente utilizados em RL devido à sua flexibilidade e capacidade de encontrar políticas ótimas em ambientes complexos e de grande escala. Eles são especialmente eficazes em problemas onde a estrutura de recompensa é desconhecida ou difícil de modelar.

Estratégias de Aprendizado em RL: Exploração vs. Explotação

Nesta seção, vamos discutir as estratégias de aprendizado em Aprendizado por Reforço (RL), com foco na exploração vs. explotação. Como agentes de RL buscam maximizar suas recompensas em um ambiente desconhecido, eles se deparam com o desafio de encontrar um equilíbrio entre explorar o ambiente em busca de novas informações e explorar o conhecimento adquirido para otimizar suas ações.

A exploração envolve a busca ativa por ações e estados desconhecidos, permitindo que os agentes descubram diferentes possibilidades e experimentem novas estratégias. Por outro lado, a explotação se baseia no conhecimento prévio adquirido, levando os agentes a aproveitar as ações que já se mostraram bem-sucedidas.

Uma abordagem excessivamente exploratória pode resultar em um gasto excessivo de tempo e recursos em ações pouco recompensadoras ou até mesmo prejudiciais. Por outro lado, uma abordagem excessivamente exploradora pode levar à falta de experimentação e à perda de oportunidades de maximizar a recompensa.

Por isso, é fundamental encontrar um equilíbrio adequado entre exploração e explotação. Existem várias estratégias comuns de exploração e explotação utilizadas em RL.

Algumas estratégias de exploração incluem:

- ε-Greedy: Essa estratégia escolhe a melhor ação com probabilidade ε e uma ação aleatória com probabilidade 1-ε.

- Boltzmann Exploration: Essa estratégia usa uma distribuição de probabilidades baseada nas ações e na temperatura para escolher a próxima ação.

- Exploração por Aleatoriedade: Os agentes tomam ações completamente aleatórias, sem levar em consideração nenhum aprendizado prévio.

Algumas estratégias de explotação incluem:

- Exploitation Plus Exploration (E+): Combina exploração e explotação, atribuindo um valor ponderado a cada ação.

- Upper Confidence Bound (UCB): Essa estratégia calcula um intervalo de confiança para cada ação, escolhendo a ação com o valor máximo do intervalo.

- Thompson Sampling: Essa estratégia atribui probabilidades a cada ação com base em amostras do modelo probabilístico.

O uso de estratégias de exploração e explotação dependerá do contexto e da natureza específica do problema em que o aprendizado por reforço está sendo aplicado. É fundamental escolher as estratégias corretas para que os agentes de RL possam tomar decisões efetivas em ambientes complexos.

Confira a tabela abaixo para uma comparação visual das estratégias de exploração e explotação em RL:

| Estratégia | Descrição |

|---|---|

| ε-Greedy | Escolhe a melhor ação com probabilidade ε e uma ação aleatória com probabilidade 1-ε. |

| Boltzmann Exploration | Usa uma distribuição de probabilidades baseada nas ações e na temperatura para escolher a próxima ação. |

| Exploração por Aleatoriedade | Tomada de ações completamente aleatórias, sem levar em consideração nenhum aprendizado prévio. |

| Exploitation Plus Exploration (E+) | Combina exploração e explotação, atribuindo um valor ponderado a cada ação. |

| Upper Confidence Bound (UCB) | Calcula um intervalo de confiança para cada ação e escolhe a ação com o valor máximo do intervalo. |

| Thompson Sampling | Atribui probabilidades a cada ação com base em amostras do modelo probabilístico. |

Transferência de Aprendizagem e Meta-Aprendizado em RL

A transferência de aprendizagem é uma técnica que busca aproveitar o conhecimento adquirido em uma tarefa para acelerar o aprendizado em uma tarefa relacionada. No contexto do aprendizado por reforço, a transferência de aprendizagem permite que um agente utilize experiências prévias para melhorar seu desempenho em novas tarefas sem a necessidade de começar do zero. Isso é especialmente útil quando enfrentamos problemas complexos e o tempo de treinamento é um fator crítico.

O meta-aprendizado, por sua vez, é uma área de pesquisa que se concentra em desenvolver algoritmos capazes de aprender a aprender. Isso significa que os agentes de aprendizado por reforço podem adquirir habilidades de adaptação em diferentes cenários e aprender a selecionar estratégias de aprendizado eficientes para cada situação. O meta-aprendizado tem o potencial de acelerar ainda mais o processo de aprendizado e melhorar a capacidade de generalização dos agentes.

Aprendizagem por Reforço Hierárquico e Multiagente

O aprendizado por reforço hierárquico é uma abordagem que visa resolver problemas complexos dividindo-os em subtarefas menores. Isso permite que o agente aprenda a executar ações em várias camadas de abstração, o que leva a uma aprendizagem mais eficiente e resultados mais consistentes. A aprendizagem hierárquica tem demonstrado resultados promissores em diferentes domínios, como jogos de estratégia e robótica.

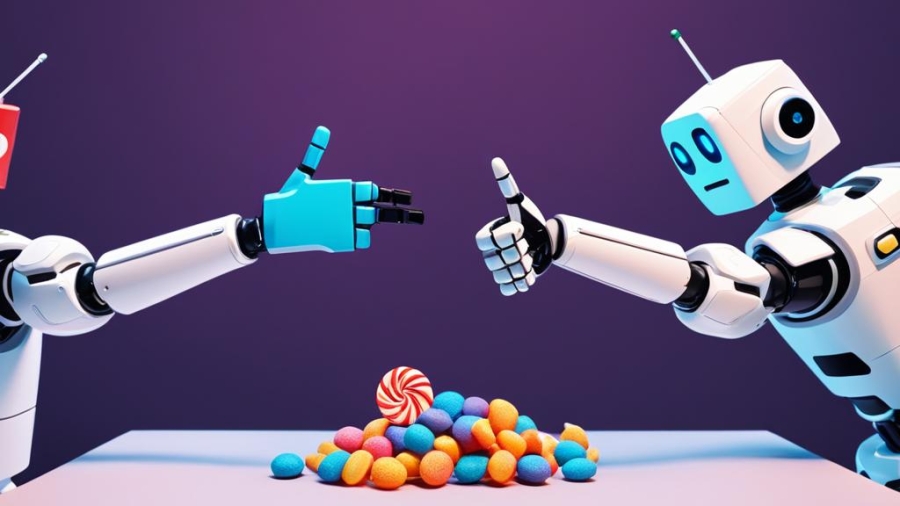

O aprendizado por reforço multiagente envolve a interação de vários agentes de aprendizado em um ambiente compartilhado. Essa abordagem possibilita a cooperação, competição e negociação entre os agentes, o que pode levar a estratégias de aprendizado mais sofisticadas e uma melhor adaptação a cenários complexos. O aprendizado multiagente tem sido aplicado em áreas como negociação automatizada e sistemas de transporte inteligentes.

| Tendências Futuras | Descrição |

|---|---|

| Transferência de Aprendizagem | Técnica que utiliza conhecimento prévio para melhorar o desempenho do agente em novas tarefas |

| Meta-Aprendizado | Desenvolvimento de algoritmos capazes de aprender a aprender e adaptar o processo de aprendizado |

| Aprendizagem por Reforço Hierárquico | Abordagem que divide problemas complexos em subtarefas menores para uma aprendizagem mais eficiente |

| Aprendizagem por Reforço Multiagente | Utilização de vários agentes de aprendizado em um ambiente compartilhado para estratégias mais sofisticadas |

Desafios e Questões Éticas no Aprendizado por Reforço

Nesta seção, vamos discutir os desafios e questões éticas no campo do aprendizado por reforço. O uso dessa poderosa técnica de inteligência artificial traz consigo implicações e dilemas que merecem atenção. Vamos abordar o dilema da privacidade de dados, que envolve o acesso e o uso adequado das informações pessoais dos usuários.

Essas são apenas algumas das principais ferramentas, recursos e comunidades disponíveis para quem deseja aprender mais sobre o aprendizado por reforço. Explore essas opções e encontre as que mais se adequam às suas necessidades e interesses. Lembre-se de que o aprendizado por reforço é um campo em constante evolução, portanto, é importante continuar aprendendo e acompanhando as novidades.

Conclusão

Após explorar os fundamentos do aprendizado por reforço, suas aplicações e os métodos mais avançados, concluímos que essa técnica tem um papel fundamental no campo da inteligência artificial e automação. O aprendizado por reforço oferece aos agentes a capacidade de aprender a partir da interação com o ambiente, obtendo recompensas e ajustando suas ações com base em experiências passadas.

Destacamos a importância dos Processos de Decisão de Markov (MDPs) e da Equação de Bellman no aprendizado por reforço, pois esses conceitos fornecem a base matemática para modelar problemas de decisão sequenciais e calcular valores de recompensa ao longo do tempo.

Reconhecemos que o aprendizado por reforço não se limita apenas aos conceitos básicos, mas também avança para áreas como o aprendizado profundo (DRL), o uso de redes neurais e as abordagens avançadas de solução. Além disso, examinamos casos de uso reais e discutimos as tendências futuras, como a transferência de aprendizado e o meta-aprendizado, que prometem acelerar o processo de aprendizado e melhorar o desempenho dos agentes em tarefas complexas.

Ao encerrar este guia completo sobre aprendizado por reforço, gostaria de enfatizar a importância de continuar sua jornada de aprendizado em RL. Mantenha-se atualizado sobre as ferramentas, recursos e comunidades disponíveis, para que você possa explorar novos horizontes e contribuir para o avanço dessa empolgante área da ciência da computação. O aprendizado por reforço está moldando o futuro da inteligência artificial e, com dedicação e perseverança, você pode ser parte dessa evolução!

Perguntas frequentes

O que é aprendizado por reforço?

O aprendizado por reforço é um tipo de algoritmo de inteligência artificial que permite que um agente aprenda a tomar decisões em um ambiente desconhecido, através de tentativa e erro, com base nas recompensas ou penalidades recebidas.

Como funciona o aprendizado por reforço?

No aprendizado por reforço, um agente interage com um ambiente e toma ações para maximizar as recompensas. Ele aprende através da tentativa e erro, ajustando sua política de ação com base nas recompensas recebidas ao longo do tempo.

Qual é a diferença entre o aprendizado por reforço e outras abordagens de aprendizado de máquina?

O aprendizado por reforço difere de outras abordagens de aprendizado de máquina, como o aprendizado supervisionado e o aprendizado não supervisionado, porque não requer dados rotulados para treinamento. Em vez disso, ele aprende a partir de feedback em forma de recompensas ou penalidades.

O que são Processos de Decisão de Markov (MDPs)?

Processos de Decisão de Markov (MDPs) são modelos matemáticos usados no aprendizado por reforço para representar problemas de decisão sequenciais. Eles consistem em um conjunto de estados, ações, recompensas e uma função de transição que descreve como o ambiente muda de um estado para outro.

Como a Equação de Bellman é utilizada no aprendizado por reforço?

A Equação de Bellman é usada no aprendizado por reforço para calcular o valor ideal de realizar uma ação em determinado estado, considerando as recompensas futuras esperadas. Ela fornece uma maneira de avaliar a qualidade das ações em um ambiente de aprendizado por reforço.

Quais são os métodos de solução utilizados no aprendizado por reforço?

Alguns dos métodos de solução utilizados no aprendizado por reforço são o Q-Learning, que ajusta os valores das ações em cada estado, e os métodos de gradiente de política, que otimizam direta ou indiretamente a política do agente com base nas recompensas recebidas.

O que é explorar vs. explorar no aprendizado por reforço?

Explorar vs. explorar é o equilíbrio entre buscar novas informações sobre o ambiente (explorar) e aproveitar as melhores ações conhecidas (explorar). No aprendizado por reforço, os agentes enfrentam o dilema de decidir entre explorar ações que ainda não foram tentadas ou explorar ações que são conhecidas por funcionar bem.

O que é Aprendizado por Reforço Profundo (DRL)?

O Aprendizado por Reforço Profundo (DRL) é uma abordagem avançada que combina aprendizado por reforço com redes neurais profundas. Ele permite que os agentes lidem com ambientes complexos, como jogos de vídeo ou robótica, e aprendam diretamente a partir dos dados brutos do ambiente.

Quais são as principais aplicações do aprendizado por reforço no mundo real?

O aprendizado por reforço tem diversas aplicações no mundo real. Algumas delas incluem jogos, robótica e controle, gerenciamento de recursos, saúde, finanças e negociação. Essas aplicações ajudam a resolver problemas complexos e a tomar decisões ótimas em diferentes áreas.

Quais são as tendências futuras em aprendizado por reforço?

Algumas das tendências futuras em aprendizado por reforço incluem a transferência de aprendizagem e o meta-aprendizado, que visam acelerar o processo de aprendizado em novas tarefas, e o aprendizado por reforço hierárquico e multiagente, que dividem problemas complexos em subtarefas menores.

Quais são os desafios e questões éticas no aprendizado por reforço?

Alguns dos desafios e questões éticas no aprendizado por reforço incluem o dilema da privacidade de dados, o uso de aprendizado por reforço inverso e as implicações éticas na tomada de decisão dos agentes. É importante abordar esses desafios para garantir um comportamento seguro e confiável dos agentes de aprendizado por reforço.

Quais são as principais ferramentas, recursos e comunidades para aprender aprendizado por reforço?

Existem diversas ferramentas, recursos e comunidades disponíveis para quem deseja aprender aprendizado por reforço. Algumas das ferramentas incluem plataformas de simulação e bibliotecas de código aberto. Recursos como livros, cursos online e tutoriais também são úteis para aprender sobre o assunto. Além disso, existem comunidades de RL onde é possível conectar-se com outros entusiastas e profissionais do campo.

Add a Comment