Você sabia que a escolha das métricas para avaliar seus algoritmos de aprendizado de máquina é fundamental? Neste artigo, vamos explorar diversas métricas de avaliação para problemas de aprendizado de máquina do tipo classificação e regressão, que fornecerão insights valiosos sobre o desempenho do seu modelo.

Quando se trata de avaliar o desempenho de um modelo de aprendizado de máquina, não se pode contar apenas com a intuição ou suposições. É crucial utilizar métricas objetivas para medir sua eficácia e comparar diferentes algoritmos. Essas métricas nos ajudam a entender como nossos modelos estão performando e se estão fornecendo resultados consistentes e confiáveis.

Principais pontos abordados neste artigo:

- As métricas mais comumente usadas na avaliação de modelos de aprendizado de máquina;

- A importância da acurácia de classificação;

- A perda logarítmica como métrica de desempenho;

- A análise da área sob a curva ROC;

- A matriz de confusão como ferramenta de avaliação;

- O relatório de classificação e suas medidas-chave.

Pontos Principais:

- As métricas são fundamentais para avaliar o desempenho de modelos de aprendizado de máquina;

- A acurácia de classificação é a métrica mais comum para problemas de classificação;

- A perda logarítmica mede o desempenho de um modelo a partir de valores de probabilidade;

- A área sob a curva ROC analisa a capacidade de discriminação do modelo;

- A matriz de confusão fornece informações visuais sobre o desempenho do modelo;

- O relatório de classificação é útil para avaliar modelos em problemas de classificação com classes desbalanceadas.

Métricas de Classificação

Problemas de classificação são talvez o tipo mais comum de problema de aprendizado de máquina. Neste artigo, vamos revisar as métricas de avaliação mais comumente usadas para problemas de classificação, incluindo a acurácia de classificação, perda logarítmica, área sob a curva (ROC), matriz de confusão e relatório de classificação.

Quando se trata de avaliar o desempenho de modelos de aprendizado de máquina em problemas de classificação, é crucial utilizar métricas confiáveis. Isso nos permite medir a eficácia e confiabilidade dos nossos algoritmos, além de fornecer insights valiosos sobre sua capacidade de generalização. As métricas discutidas nesta seção nos ajudarão a compreender melhor o desempenho dos nossos modelos e tomar decisões informadas na melhoria e otimização dos mesmos.

Acurácia de Classificação

A acurácia de classificação é uma das métricas mais simples e amplamente utilizadas para avaliar modelos de classificação. Ela mede a proporção de previsões corretas feitas pelo modelo em relação a todas as previsões realizadas. A fórmula para calcular a acurácia é:

Acurácia = (Número de previsões corretas) / (Número total de previsões)

A acurácia de classificação é útil quando todas as classes possuem igual importância e quando os falsos positivos e falsos negativos são igualmente indesejados. No entanto, é importante observar que a acurácia pode ser enganosa em casos de classes desbalanceadas, onde o número de exemplos de uma classe é significativamente maior do que o número de exemplos das outras classes.

Perda Logarítmica

A perda logarítmica (log loss) é uma medida de desempenho amplamente utilizada para modelos de classificação que geram probabilidades de categorias ao invés de previsões binárias. Essa métrica penaliza previsões com maior incerteza ou divergência das probabilidades reais.

A fórmula para calcular a perda logarítmica é:

Perda logarítmica = (-1 / N) * Σ [y * log(p) + (1 – y) * log(1 – p)]

Onde:

- N é o número de exemplos no conjunto de teste

- y é o rótulo verdadeiro da classe (0 ou 1)

- p é a probabilidade prevista da classe

Quanto menor for o valor da perda logarítmica, melhor é o desempenho do modelo. Essa métrica é especialmente útil quando queremos calibrar nossos modelos de classificação em termos de probabilidades.

Área Sob a Curva (ROC)

A área sob a curva (AUC) é uma métrica que avalia a capacidade de um modelo de classificação binária de distinguir corretamente entre duas classes. Ela é calculada traçando a curva ROC (Receiver Operating Characteristic) com base nas taxas de verdadeiros positivos (sensibilidade) e taxas de verdadeiros negativos (especificidade).

A AUC varia de 0 a 1, onde 0,5 indica um modelo que não possui habilidade de discriminação entre as classes, e 1 indica um modelo ideal que é capaz de fazer todas as previsões corretamente.

Matriz de Confusão

A matriz de confusão é uma tabela que resume o desempenho de um algoritmo de classificação, mostrando a contagem de verdadeiros positivos (TP), falsos positivos (FP), verdadeiros negativos (TN) e falsos negativos (FN). Ela nos permite ter uma visão mais detalhada do desempenho do modelo em todas as classes.

Aqui está um exemplo de uma matriz de confusão:

| Classe positiva | Classe negativa | |

|---|---|---|

| Previsão positiva | TP | FP |

| Previsão negativa | FN | TN |

Essa tabela nos permite visualizar facilmente o número de acertos e erros do modelo para cada classe, o que é fundamental para melhorar o desempenho.

Acurácia de Classificação

A acurácia de classificação é uma métrica fundamental para avaliar o desempenho de modelos de aprendizado de máquina em problemas de classificação. Essa métrica mede a proporção de previsões corretas feitas pelo modelo em relação ao total de previsões realizadas.

Por exemplo, se temos um modelo que realiza 100 previsões e acerta 80 delas, a acurácia de classificação é igual a 80%. Essa métrica é de fácil interpretação e amplamente utilizada em diferentes contextos.

No entanto, é importante considerar as limitações da acurácia de classificação. Ela não leva em conta o desempenho do modelo em cada classe individualmente, podendo ser influenciada pelo desbalanceamento dos dados. Um exemplo disso é quando temos um conjunto de dados com uma classe majoritária e uma classe minoritária. Se o modelo sempre prever a classe majoritária, ele poderá apresentar uma alta acurácia mesmo cometendo muitos erros na classe minoritária.

Portanto, é essencial avaliar outras métricas além da acurácia de classificação para obter uma visão mais completa do desempenho do modelo. Essas métricas podem incluir a matriz de confusão, que permite analisar o desempenho em cada classe individualmente, e outras medidas de precisão, recall e F1-score, que oferecem uma perspectiva mais detalhada da performance do modelo em relação às classes positivas e negativas.

Matriz de Confusão

Uma métrica complementar à acurácia de classificação é a matriz de confusão. Essa métrica fornece uma representação visual dos resultados das previsões do modelo, permitindo uma avaliação mais detalhada do seu desempenho em cada classe.

A matriz de confusão é uma tabela que relata o número de falsos positivos, falsos negativos, verdadeiros positivos e verdadeiros negativos feitos pelo modelo em um problema de classificação. Com base nesses valores, podemos calcular métricas como a precisão, recall e F1-score.

Por exemplo, imagine que temos um problema de classificação binária com duas classes: classe A e classe B. A matriz de confusão pode ser representada da seguinte forma:

| Classe A (Previsto) | Classe B (Previsto) | |

|---|---|---|

| Classe A (Real) | Verdadeiro Positivo (VP) | Falso Negativo (FN) |

| Classe B (Real) | Falso Positivo (FP) | Verdadeiro Negativo (VN) |

A partir da matriz de confusão, podemos calcular diferentes métricas para avaliar o desempenho do modelo, como a acurácia de classificação, a sensibilidade (taxa de verdadeiros positivos) e a especificidade (taxa de verdadeiros negativos).

Em resumo, embora a acurácia de classificação seja uma métrica importante, ela deve ser considerada em conjunto com outras métricas, como a matriz de confusão e medidas de precisão, recall e F1-score, para obter uma avaliação abrangente do desempenho do modelo de aprendizado de máquina.

Perda Logarítmica

A perda logarítmica é uma métrica crucial para avaliar o desempenho de modelos de classificação. Essa métrica permite medir o quão bem um modelo está calibrado em termos de probabilidades, levando em consideração a divergência de probabilidade entre as previsões e os valores reais.

Quando a entrada de previsão é um valor de probabilidade entre 0,00 e 1,00, a perda logarítmica quantifica o quão distante as probabilidades previstas estão dos valores verdadeiros. Quanto maior a divergência, maior será a pontuação de perda logarítmica.

A perda logarítmica é especialmente útil em problemas de classificação onde a saída desejada é uma probabilidade. Ao utilizar essa métrica, é possível obter informações mais detalhadas sobre o desempenho do modelo, permitindo uma análise mais precisa de seus resultados.

Por exemplo, imagine um modelo de classificação que realiza previsões baseadas em probabilidades. Se a probabilidade prevista para uma classe específica diminuir consideravelmente em relação ao valor real, a pontuação de perda logarítmica aumentará, indicando um desempenho subóptimo do modelo nessa situação.

Por outro lado, se as probabilidades previstas estiverem próximas aos valores reais, a perda logarítmica será reduzida, sinalizando um melhor desempenho do modelo em termos de calibração de probabilidades.

A perda logarítmica é uma métrica essencial para entender a confiabilidade das previsões do seu modelo de classificação e analisar como ele está se comportando em termos de calibração de probabilidades. Utilizar essa métrica pode auxiliar no processo de tomada de decisões informadas sobre o desenvolvimento e otimização de algoritmos de aprendizado de máquina.

Continue lendo para descobrir mais métricas importantes para avaliar modelos de classificação.

Área Sob a Curva ROC

A área sob a curva ROC é uma métrica amplamente utilizada na avaliação de modelos de classificação binária. Ela representa a capacidade de um modelo em discriminar entre as classes positivas e negativas, analisando a taxa de verdadeiros positivos (sensibilidade) e a taxa de verdadeiros negativos (especificidade).

Essa métrica é especialmente útil para medir a capacidade de um modelo em classificar corretamente os casos positivos e negativos, proporcionando uma medida mais abrangente do desempenho do modelo, além da simples acurácia de classificação.

Uma área sob a curva igual a 1 indica que o modelo é capaz de distinguir perfeitamente entre as classes, sendo considerado ideal. Já uma área igual a 0,5 indica que o modelo não possui capacidade discriminante e não consegue diferenciar as classes de forma alguma.

A área sob a curva ROC oferece uma análise completa do desempenho do modelo em relação a diferentes pontos de corte do limiar de decisão, permitindo uma escolha mais informada do limiar ideal para cada problema.

“A área sob a curva ROC é uma métrica essencial para avaliar a capacidade de discriminação de um modelo de classificação binária.” – [nome do especialista]

| Métricas | Definição |

|---|---|

| Sensibilidade | Taxa de verdadeiros positivos em relação a todos os casos positivos |

| Especificidade | Taxa de verdadeiros negativos em relação a todos os casos negativos |

Matriz de Confusão

A matriz de confusão é uma ferramenta essencial para a avaliação do desempenho de algoritmos de aprendizado de máquina em problemas de classificação. Ela oferece uma visão detalhada e visualmente representativa dos resultados das previsões do modelo, possibilitando uma análise minuciosa do seu desempenho.

A matriz de confusão é composta por quatro elementos principais:

- Verdadeiros Positivos (VP): são os casos em que o modelo classificou corretamente uma instância como positiva.

- Verdadeiros Negativos (VN): representam os casos em que o modelo classificou corretamente uma instância como negativa.

- Falsos Positivos (FP): são os casos em que o modelo classificou incorretamente uma instância como positiva, quando na verdade era negativa.

- Falsos Negativos (FN): indicam os casos em que o modelo classificou incorretamente uma instância como negativa, quando na verdade era positiva.

A matriz de confusão organiza esses elementos em uma tabela, permitindo uma análise visual imediata das proporções de verdadeiros positivos, verdadeiros negativos, falsos positivos e falsos negativos. Dessa forma, é possível avaliar a capacidade do modelo em identificar corretamente as classes positivas e negativas e identificar erros comuns de classificação.

Segue abaixo um exemplo de matriz de confusão:

| Classe Positiva | Classe Negativa | |

|---|---|---|

| Previsto Positivo | Verdadeiros Positivos (VP) | Falsos Positivos (FP) |

| Previsto Negativo | Falsos Negativos (FN) | Verdadeiros Negativos (VN) |

Ao analisar a matriz de confusão, é possível extrair diversas métricas para avaliar o desempenho do algoritmo de aprendizado de máquina, como a acurácia, precisão, recall, dentre outras. Essas métricas são fundamentais para uma avaliação completa e precisa do modelo e auxiliam na tomada de decisões informadas no processo de desenvolvimento e otimização do algoritmo.

A matriz de confusão, juntamente com as métricas derivadas dela, proporciona uma compreensão abrangente do desempenho do algoritmo em relação à classificação das instâncias, permitindo identificar a ocorrência de falsos positivos, falsos negativos, verdadeiros positivos e verdadeiros negativos de forma clara e intuitiva.

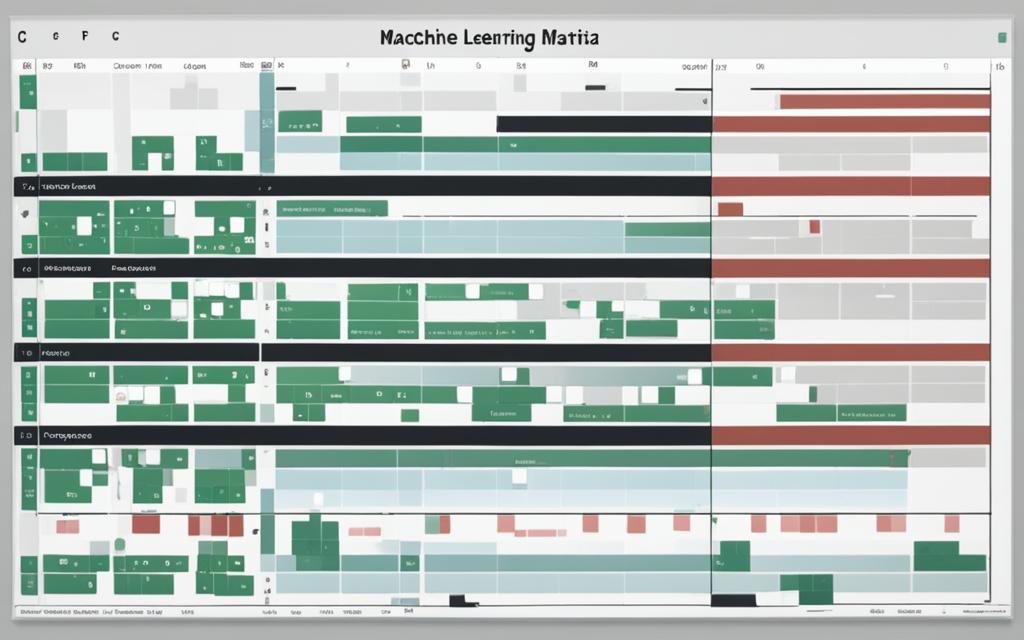

Relatório de Classificação

O relatório de classificação é uma ferramenta útil para avaliar e comparar modelos de classificação. Ele fornece informações sobre a precisão, recall, F1-score e suporte de cada classe prevista pelo modelo. O relatório de classificação é especialmente útil quando lidamos com problemas de classificação com classes desbalanceadas.

Medidas de Precisão, Recall, F1-score e Suporte

Ao avaliar um modelo de classificação, é importante considerar várias medidas de desempenho. O relatório de classificação fornece quatro medidas chave: precisão, recall, F1-score e suporte.

- Precisão: A precisão mede a proporção de previsões corretamente classificadas como positivas em relação a todas as previsões positivas feitas pelo modelo. É calculada usando a fórmula:

- Recall: O recall (também conhecido como taxa de verdadeiros positivos) mede a proporção de previsões corretamente classificadas como positivas em relação a todas as instâncias positivas reais. É calculado usando a fórmula:

- F1-score: O F1-score é a média harmônica entre a precisão e o recall e fornece uma única medida resumida do desempenho do modelo. É calculado usando a fórmula:

- Suporte: O suporte é o número de instâncias reais de cada classe no conjunto de dados. Ele fornece informações sobre o desequilíbrio das classes e é útil quando se lida com problemas de classificação com classes desbalanceadas.

Precisão = Verdadeiros Positivos / (Verdadeiros Positivos + Falsos Positivos)

Recall = Verdadeiros Positivos / (Verdadeiros Positivos + Falsos Negativos)

F1-score = 2 * (Precisão * Recall) / (Precisão + Recall)

O relatório de classificação agrupa essas medidas por classe prevista e apresenta uma visão geral do desempenho do modelo em cada classe. Isso permite uma análise mais detalhada do quão bem o modelo está lidando com diferentes classes e ajuda na seleção do modelo mais adequado para um determinado problema de classificação.

| Classe | Precisão | Recall | F1-score | Suporte |

|---|---|---|---|---|

| Classe 1 | 0.85 | 0.92 | 0.88 | 50 |

| Classe 2 | 0.78 | 0.71 | 0.74 | 80 |

| Classe 3 | 0.92 | 0.87 | 0.89 | 30 |

A tabela acima mostra um exemplo fictício de um relatório de classificação para um modelo de classificação com três classes. Cada linha representa uma classe prevista pelo modelo e apresenta a precisão, recall, F1-score e suporte correspondentes. Esses números fornecem insights valiosos sobre o desempenho do modelo em cada classe e podem ser usados para comparar diferentes modelos de classificação ou ajustar parâmetros do modelo.

Conclusão

Neste artigo, exploramos várias métricas de avaliação essenciais para avaliar o desempenho de modelos de aprendizado de máquina em problemas de classificação. As métricas discutidas, como acurácia de classificação, perda logarítmica, área sob a curva ROC, matriz de confusão e relatório de classificação, fornecem insights valiosos para avaliar a eficácia do modelo e auxiliam na tomada de decisões informadas durante o desenvolvimento e otimização dos algoritmos de aprendizado de máquina. É fundamental realizar uma avaliação precisa do desempenho do modelo para garantir sua confiabilidade e eficácia em diferentes cenários.

A avaliação do desempenho do modelo de aprendizado de máquina é um processo complexo, que requer a seleção cuidadosa das métricas adequadas ao problema em questão. Cada métrica fornece uma perspectiva única sobre o desempenho do modelo, levando em consideração aspectos como a precisão das previsões, a calibração das probabilidades previstas e a capacidade de discriminação entre classes. Ao utilizar e analisar um conjunto abrangente de métricas, é possível obter uma visão mais completa e embasada sobre o desempenho do modelo.

A escolha das métricas apropriadas depende da natureza do problema de classificação e dos requisitos específicos do projeto. Por exemplo, a acurácia de classificação é uma métrica simples e fácil de interpretar, mas pode não ser adequada para lidar com classes desbalanceadas. Nesses casos, métricas como o F1-score ou a área sob a curva ROC podem fornecer uma avaliação mais robusta.

Em suma, a avaliação do desempenho do modelo de aprendizado de máquina é um componente crucial no desenvolvimento de algoritmos eficazes. Ao compreender e utilizar as métricas corretas, os especialistas em aprendizado de máquina podem melhorar a precisão e a confiabilidade de seus modelos, tornando-os mais eficientes em uma ampla variedade de aplicações.

FAQ

Quais métricas podem ser usadas para avaliar o desempenho de um modelo de aprendizado de máquina?

Algumas métricas comumente usadas para avaliar o desempenho de um modelo de aprendizado de máquina incluem acurácia de classificação, perda logarítmica, área sob a curva (ROC), matriz de confusão e relatório de classificação.

O que é acurácia de classificação?

A acurácia de classificação é uma métrica que mede o número de previsões corretas feitas por um modelo como uma proporção de todas as previsões realizadas.

O que é perda logarítmica?

A perda logarítmica é uma métrica que mede o desempenho de um modelo de classificação quando a entrada de previsão é um valor de probabilidade entre 0,00 e 1,00.

O que é área sob a curva ROC?

A área sob a curva ROC é uma métrica comumente usada para problemas de classificação binária. Ela representa a capacidade de um modelo em discriminar entre classes positivas e negativas, analisando a taxa de verdadeiros positivos (sensibilidade) e a taxa de verdadeiros negativos (especificidade).

O que é matriz de confusão?

A matriz de confusão é uma tabela que relata o número de falsos positivos, falsos negativos, verdadeiros positivos e verdadeiros negativos feitos por um algoritmo de aprendizado de máquina em um problema de classificação.

O que é relatório de classificação?

O relatório de classificação é uma ferramenta útil para avaliar e comparar modelos de classificação. Ele fornece informações sobre a precisão, recall, F1-score e suporte de cada classe prevista pelo modelo.

Add a Comment